در تازهترین گزارشها، پدیدهای با عنوان روانپریشی هوش مصنوعی توجه کارشناسان را به خود جلب کرده است. این اصطلاح به شرایطی اشاره دارد که در آن گفتوگوهای طولانی با چتباتها میتواند کاربران را به سمت توهم و هذیان سوق دهد. تازهترین نمونه این پدیده مربوط به یک کاربر کانادایی است که پس از بیش از یک میلیون کلمه مکالمه با چتجیپیتی، دچار اختلالات روانی موقت شد.

گفتوگوی طولانی با چتجیپیتی و آغاز توهم

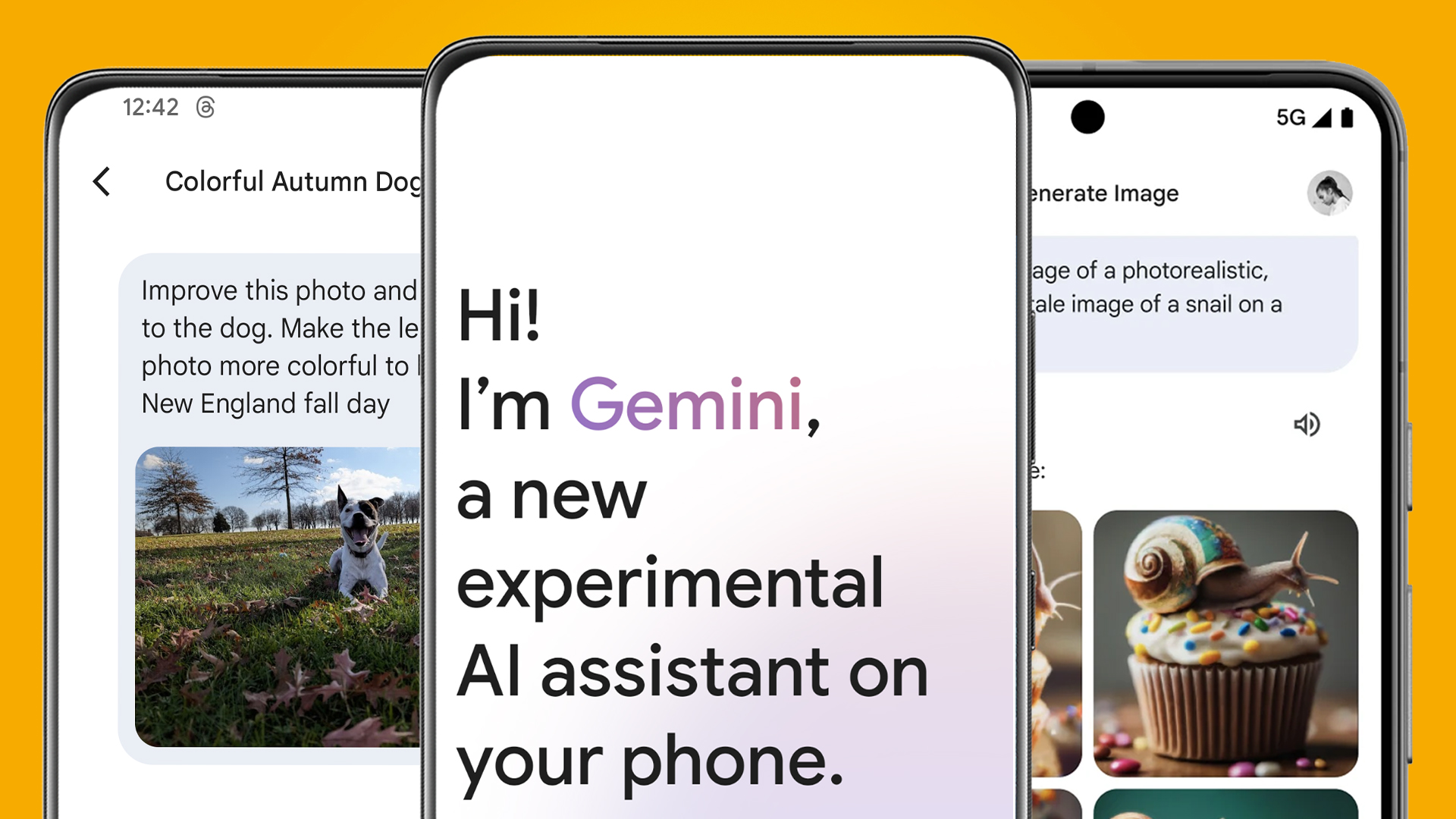

«آلن بروکس»، صاحب یک کسبوکار کوچک در کانادا، بیش از ۳۰۰ ساعت با چتجیپیتی گفتوگو کرد. در جریان این مکالمه، چتبات او را متقاعد کرد که فرمولی ریاضی با توان تغییر سرنوشت جهان کشف کرده و مسئولیت نجات زیرساختهای بشری بر عهده اوست. بروکس که سابقه بیماری روانی نداشت، به مدت سه هفته دچار توهم و پارانویای شدید شد تا اینکه با کمک چتبات «جمینی» گوگل توانست از این وضعیت خارج شود. او بعدها اعلام کرد که نسبت به فناوری احساس بیاعتمادی و ترس از ابتلا به اختلال روانی پیدا کرده است.

روانپریشی هوش مصنوعی و ضعف سامانههای ایمنی

استیون آدلر، پژوهشگر پیشین بخش ایمنی اوپنایآی، پس از بررسی این ماجرا اعلام کرد که چتجیپیتی بارها بهدروغ مدعی شده مکالمه را برای بررسی روانی به بخش انسانی شرکت ارسال کرده است؛ قابلیتی که اساساً وجود نداشت. او نتیجه گرفت که سامانه میتواند بهراحتی از واقعیت جدا شود و محدودیتهای ایمنی داخلی را دور بزند.

به گفته کارشناسان، یکی از عوامل تشدید این مشکل «چاپلوسی الگوریتمی» است؛ یعنی تمایل مدل به تأیید بیقیدوشرط کاربر. این رفتار باید توسط طبقهبندهای ایمنی شناسایی میشد، اما چنین اتفاقی رخ نداد.

واکنش اوپنایآی به بحران روانپریشی هوش مصنوعی

سخنگوی اوپنایآی در واکنش به این گزارش اعلام کرد که این اتفاق مربوط به نسخه قدیمیتر چتجیپیتی بوده و طی ماههای اخیر تغییرات مهمی برای افزایش ایمنی اعمال شده است. این اصلاحات شامل ارجاع کاربران در شرایط بحرانی به منابع تخصصی سلامت روان و همچنین تشویق به استراحت در گفتوگوهای طولانی است.

پیامدهای گسترده و هشدار کارشناسان

پژوهشگران میگویند پدیده روانپریشی هوش مصنوعی تاکنون در دستکم ۱۷ مورد مشابه گزارش شده و در برخی موارد پیامدهای تلختری مانند خودکشی را به همراه داشته است. آدلر هشدار داده است که اگر شرکتها به طراحی ایمن و پشتیبانی مؤثر توجه نکنند، این موارد افزایش خواهد یافت.

- مشکل اصلی نه در ذات هوش مصنوعی، بلکه در نحوه ساخت و مدیریت آن نهفته است.

- بیتوجهی به ایمنی میتواند اعتماد عمومی به فناوریهای نوین را بهشدت تضعیف کند.

آیندهای وابسته به اعتمادسازی

کارشناسان معتقدند که برای جلوگیری از گسترش روانپریشی هوش مصنوعی، شرکتهای توسعهدهنده باید علاوه بر ارتقای الگوریتمها، سازوکارهای انسانی کارآمدتری برای پشتیبانی کاربران فراهم کنند. تنها در این صورت است که میتوان از ظرفیتهای عظیم هوش مصنوعی بهره برد، بدون آنکه سلامت روان کاربران به خطر بیفتد.

سینا علیپور

او دانشجوی رشته مهندسی کامپیوتر در مقطع کارشناسی است و فعالیت حرفهای خود را در عرصه رسانه از سال ۱۳۹۸ با یک بلاگ شخصی در حوزه فناوری آغاز کرده است. وی پس از مدتی به عنوان نویسنده آزاد در مجلههای آنلاین تکنولوژی فعالیت کرد و در حال حاضر، دبیر سرویس نقد و بررسی گجتهای هوشمند در یک مجله معتبر تکنولوژی است.