هوش مصنوعی: ورود به اعماق تاریک ذهن با خطرات بالقوه

حادثه اخیر یک کاربر تیک تاک که در ویدئویی اعتراف کرد از چت جی پی تی برای حل مسائل روحی خود استفاده می کند، زنگ خطری را در مورد خطرات احتمالی به صدا درآورد.

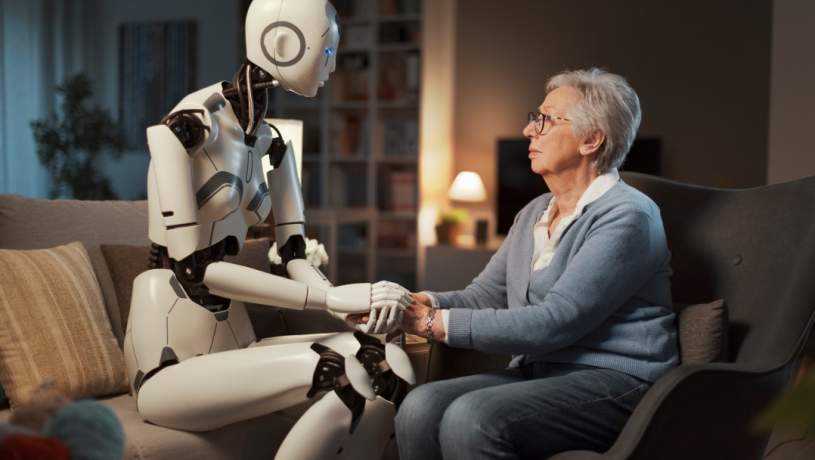

علی رغم تعجب برخی کاربران، افراد زیادی از چت جی پی تی برای مشاوره در زمینه روابط، سبک زندگی و حتی حل و فصل مسائل روانشناختی استفاده می کنند.

یک کاربر تیک تاک در ویدئویی نوشت: «جلسه هفتگی درمانی من اینطور است: درد و دل با چت جی پی تی بدون پنهان کردن هیچ رازی».

کاربر دیگری از چت جی پی تی خواست تا جملات الهام بخشی از سخنرانان مورد علاقه اش را ارائه دهد.

در سال 2017، «Woebot» به عنوان یک اپلیکیشن سلامت روان راه اندازی شد که از پردازش زبان طبیعی استفاده می کند.

کارل مارسی، مدیر ارشد بالینی و نویسنده کتاب «تنظیم مجدد: محافظت از مغز در عصر دیجیتال»، این پدیده را زنگ خطری برای سلامت روان می داند.

عدم تعادل بین عرضه و تقاضا در مراقبت های سلامت روان، چت جی پی تی را به عنوان راه حل بالقوه نمایان می کند. در آمریکا، یک نفر از سه نفر در منطقه ای با کمبود پرسنل سلامت روان زندگی می کند.

هزینه بالا و عدم دسترسی به خدمات درمانی، استفاده از چت جی پی تی را که پاسخ های سریع و رایگان ارائه می دهد، جذاب می کند.

اما آیا جایگزین کردن درمانگران انسانی با هوش مصنوعی ایمن است؟ چت جی پی تی فاقد اصول اخلاقی، محرمانه بودن و مسئولیت پذیری درمانگران است.

حتی خود چت جی پی تی نیز کاربران را در مورد اطلاعات نادرست و تولید محتوای مضر هشدار می دهد.

مارسی معتقد است که قابلیت اطمینان مدل های زبان بزرگ هنوز مورد تایید قرار نگرفته است. این مدل ها ممکن است به توهمات و توصیه های خطرناک در مورد خودکشی منجر شوند.

در پایان، استفاده از هوش مصنوعی در درمان مسائل روحی، خطراتی را به همراه دارد. اعماق تاریک ذهن ما باید به دست افراد واجد شرایط و اخلاقی سپرده شود، نه فناوری هایی که نگرانی های مربوط به حریم خصوصی و نظارت را برمی انگیزند.

سینا علیپور

او دانشجوی رشته مهندسی کامپیوتر در مقطع کارشناسی است و فعالیت حرفهای خود را در عرصه رسانه از سال ۱۳۹۸ با یک بلاگ شخصی در حوزه فناوری آغاز کرده است. وی پس از مدتی به عنوان نویسنده آزاد در مجلههای آنلاین تکنولوژی فعالیت کرد و در حال حاضر، دبیر سرویس نقد و بررسی گجتهای هوشمند در یک مجله معتبر تکنولوژی است.